Wetenschappers uit Nederland en Spanje ontdekten hoe een systeem voor beeldherkenning de omgeving leert herkennen.

Hoe train je een kunstmatig intelligent systeem? Die vraag is belangrijk, want veel systemen gebaseerd op 'deep learning' zijn zwarte dozen. Computerwetenschappers uit Nederland en Spanje hebben vastgesteld hoe een systeem voor beeldherkenning de omgeving leert herkennen. Daarmee wisten ze het leerproces te vereenvoudigen door het systeem te dwingen zich ook te richten op minder belangrijke informatie.

Het gaat om Convolutional Neural Networks (CCNs), een op de biologie geïnspireerde vorm van deep learning binnen de kunstmatige intelligentie (artificial intelligence, AI). Dit systeem leert beelden herkennen dankzij de interactie van duizenden 'neuronen' die de werking van onze hersenen nabootsen. "CNNs zijn erg nuttig, maar we begrijpen niet goed hoe ze werken", aldus Estefania Talavera Martinez van de Rijksuniversiteit Groningen (RUG).

Voedsel

Zij gebruikt CNNs in onderzoek naar menselijk gedrag, om beelden te analyseren die gemaakt zijn met een draagbare camera. Martinez bestudeert onder meer onze interactie met voedsel en wilde dat het systeem verschillende situaties kan herkennen waarin mensen voedsel tegen komen. Het viel daarbij op dat het systeem fouten maakte bij het goed identificeren van de omgeving op bepaalde foto’s. Martinez wilde weten waarom.

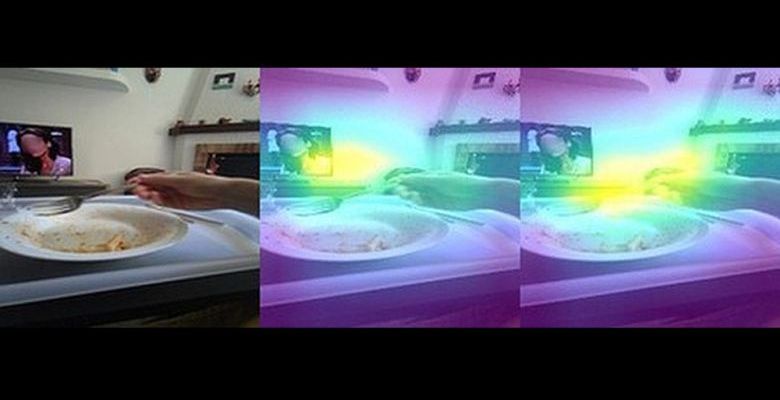

Aan de hand van 'heat maps' analyseerde ze welke delen van de beelden door de neurale netwerken zijn gebruikt om de situatie te herkennen. Dat leidde tot de hypothese dat het systeem niet voldoende details uit het beeld gebruikte. Wanneer een KI systeem bijvoorbeeld heeft geleerd om een mok te associëren met de keuken, zal het een woonkamer of kantoor met mokken verkeerd classificeren. De oplossing die Martinez samen met collega’s aan de universiteiten van Granada en van Oviedo bedacht, was om het systeem af te leiden van de primaire doelen.

Vervaagd

Ze trainden CNNs met standaardbeelden van vliegtuigen of auto’s en achterhaalden via heat maps welke delen waren gebruikt voor de classificatie. Vervolgens zijn deze delen van het beeld vervaagd, waarna een tweede trainingsronde volgde. Dit dwingt het systeem om andere delen van het beeld te gebruiken voor identificatie. Door deze extra informatie mee te nemen, ontstaat een betere classificatie.

De aanpak is vervolgens toegepast op de beelden die Martinez had verzameld met draagbare camera’s. Deze manier van trainen levert een vergelijkbaar resultaat op met andere technieken, maar is veel eenvoudiger en kost minder rekentijd.

Eerdere pogingen om de classificatie van beelden te verbeteren gebruikten bijvoorbeeld een combinatie van verschillende soorten CNNs. De aanpak die Martinez en haar collega’s gebruikten, is minder zwaar. Dit onderzoek gaf een beter idee van hoe deze CNNs leren en dat heeft geholpen het trainingsprogramma te verbeteren.

De illustratie toont het beeld van een eetkamer (links), de heatmap van dezelfde kamer voor de eerste trainingsronde van het CNN (midden), en de heat map na de tweede trainingsronde, waarbij de delen die het systeem in de eerste ronde gebruikte, waren vervaagd. Foto: Estefanía Talavera Martinez, RUG